(最終更新日: 2025年08月07日)

「AIを業務に取り入れたいけど、どのモデルを選べばいいの?」「オープンソースのAIって本当に安心?」そんな疑問や不安を抱えていませんか。

話題を集めるOpenAIの最新作「Gpt-oss」は、従来のAIモデルとは一線を画す新しい選択肢として2025年に登場しました。

本記事では、Gpt-ossの特徴や他モデルとの違い、実際の導入ステップから安全性・今後の活用まで徹底解説。本当に自社やプロジェクトに合うAI選びのヒントが得られます。

専門的な視点と最新情報をもとに、あなたの疑問をひとつずつ解消します。今注目のAI導入で一歩先を目指しましょう!

Gpt-ossとは何か?最新モデルの特徴を徹底解説

当セクションでは、OpenAIの新しいオープンウェイトモデル「Gpt-oss」とは何か、その最新モデルの特徴・設計思想・使い方までを徹底解説します。

なぜなら、Gpt-ossはAI開発の常識を変える戦略的な登場であり、開発者・ビジネス・研究の現場を問わず、今後のAI活用レベルを大きく左右するからです。

- OpenAIはなぜオープン戦略へ転換したのか

- ラインナップ:20B/120Bモデルとその活用ユースケース

- ライセンス・利用規約:Apache 2.0の真価と注意点

OpenAIはなぜオープン戦略へ転換したのか

OpenAIが再び「オープン」へ大きく舵を切った背景は、業界の勢力図と開発者ニーズの変化を的確に捉えた戦略的な判断です。

その理由は、MetaのLlamaやMistral、DeepSeekなどのオープンソースLLMが急激に成長し、開発者や企業が「自由に使えるAIモデル」を求めるニーズが絶えず高まってきたためです。

かつてGPT-2まで「オープン」が当たり前だったOpenAIですが、その後は高性能モデルをクローズドに切り替えました。しかし、拡大するオープンソースエコシステムから主導権が離れつつある危機感や、米国政府からの技術公開圧力も無視できなくなりました(OpenAI公式ブログ参照)。

こうした背景から、OpenAIは再びオープンなコミュニティへ回帰し、Gpt-ossを通じて「AI開発の業界標準」を自らの手で引き寄せ直す狙いが明確です。

ラインナップ:20B/120Bモデルとその活用ユースケース

Gpt-ossは「gpt-oss-20b」と「gpt-oss-120b」という2種類のスケーラブルなモデルで、開発者・企業それぞれに最適な選択肢を提供します。

なぜ2タイプが必要かというと、ローカルで軽快に使いたい個人や部署向け・大規模推論が必要な本番業務用など、多様なユースケースがあるからです。

具体例として、gpt-oss-20bは16GBメモリ搭載ノートPCやワークステーションでも動作し、プロトタイピングやローカルAIアプリ、個別業務の自動化等に最適です。逆にgpt-oss-120bは80GBの最新GPU(NVIDIA H100等)でクラウド/本番向けの大規模推論・エージェントアプリなど高難易度の課題解決に力を発揮します。

この2モデルの構造や性能の違いは、用途・インフラ規模・コスト意識に即した最適選択を可能にし、「AIを使いたいけど性能かコストで妥協してきた」すべての層に新しい選択肢を提供します。

ライセンス・利用規約:Apache 2.0の真価と注意点

Gpt-ossは「Apache 2.0ライセンス」で公開されており、商用・改変・再配布が非常に自由であることが最大のメリットです。

理由は、従来の多くのOSSモデルに残る“再配布制限”や“特許リスク”を気にせず、自社サービスやアプリに思い切って組み込めるからです。

たとえば私は法務部門にOSSモデル導入の相談を受けた時、「コピーレフトや再配布禁止は問題ないか」と細かい指摘をもらった経験がありますが、Apache 2.0なら多くの場合でスムーズにクリアできます(OpenAI解説ページ参照)。

ただし注目すべきは、OpenAIが独自に「責任ある利用ガイドライン」を設け、倫理的な悪用や重大な法規制違反等はNGである点です。法的には大きな自由が得られる一方、自社のモラルやリスク評価を徹底する姿勢がますます重要になるでしょう。

他のAIモデルと比べて何が違う?Gpt-ossの強みを分析

このセクションでは、Gpt-ossが他の代表的AIモデルと比べてどこが際立って異なり、どんな強みを持っているのかを掘り下げて解説します。

なぜなら、AIモデルを選ぶ際に「何がどう優れているのか?」を具体的に理解することは、実際の業務活用や導入判断の成否を大きく左右するからです。

- 推論力・専門家混合(MoE)設計が生む真の強み

- 性能比較:GPT-4oやLlama 3、Mistralとベンチマークでどう違う?

- どんな業務に最適?選択時の注意点・弱点も知ろう

推論力・専門家混合(MoE)設計が生む真の強み

Gpt-ossの最大の特徴は、「推論力」に重きを置いたMoE(専門家混合)設計による抜群の効率と賢さです。

従来のAIモデルは、全パラメータを一斉に使って計算する“フルパワー型”でしたが、Gpt-ossは入力ごとに最適な「専門家(エキスパート)」に役割分担させることで、大規模な知識とロジックを維持しつつ、実動パラメータを大幅に絞り効率化を実現しています。

たとえば、1170億パラメータのgpt-oss-120bであっても、実際に1トークンを処理する際に動くのは51億のみ──これは、渋滞で全車道を使うのではなく、最適ルート(専門家)だけを選び抜いて高速道路の流れを最速に保つイメージです。

また、この仕組みと「思考の連鎖(Chain-of-Thought)」機能や、外部ツールとのスムーズな連携設計が組み合わさり、コストと能力を高次元で両立した“自律的な推論エンジン”としての強みを発揮します。

この先進的なMoEと量子化(MXFP4)技術は、OpenAI公式発表でも“効率と多様性のイメージ革命”と表現されており、AIをクラウドでもローカルでもスマートに動かしたい人に最適な選択肢となっています。

性能比較:GPT-4oやLlama 3、Mistralとベンチマークでどう違う?

Gpt-ossの実力は、公開ベンチマークでもはっきり証明されています。

特にgpt-oss-120bモデルは、OpenAI純正の高性能プロプライエタリモデル「o4-mini」と肩を並べ、AIMEやMMLU、コーディング分野で驚くほど競り合うスコアを記録しています。

これにより、「120b=大企業・本番運用レベル」「20b=ノートPCや研究用にも強い万能ミドル」と考えてOKですが、従来OSSモデル(Llama 3、Mistral等)と比べると推論の複雑さ・数学・健康・コーディングなど“思考が必要な分野”で頭ひとつ抜けているのもポイントです。

ハード要件や目的別に選ぶ際のコツとしては、企業や開発で最高精度を求める場面では「120b(80GB VRAM)」、素早い試行・個人利用・軽量運用では「20b(16GB RAM)」がフィットするでしょう。

もし、業務でのエージェント設計やコーディング用途を重視するなら、その分野でGpt-ossの「推論力」が他を凌ぐ実例も多数存在するため、公式のベンチマーク表は必見です。

さらに他のOSSモデル比較について深掘りしたい方は、オープンソースLLM活用の戦略ガイドの最新情報もご活用ください。

どんな業務に最適?選択時の注意点・弱点も知ろう

Gpt-ossは「ローカル実行、カスタマイズ、ツール連携の柔軟性」が武器ですが、万能ではありません。

事実情報の網羅性や絶対的な安定性では、最大規模のプロプライエタリモデル(例えばGPT-4o)にやや届かない部分もあり、信頼性重視の医療・法務などでは細心の注意が必要です。

しかし、ベンダーロックフリー&低コストでAI活用をスピードUPしたい業務、複数AIとの併用(OSS+有料APIのハイブリッド運用)には、現場の制約ごと突破できる強力な武器となります。

たとえば、あるIT企業では「下書きや議論はGpt-ossで高速化し、最終診断やレビューはGPT-4o等クラウドAPIでダブルチェック」という使い分けで、品質・コスト・開発スピードのベストバランスを達成できた事例が報告されています。

このような「プロプラモデルとOSSモデルを使い分けながら、AIワークフロー全体の価値を最大化する戦略」こそ、今後多様な企業・業務で参考にしたいポイントです。

Gpt-ossを今すぐ使う!導入・活用ステップ完全ガイド

当セクションでは、OpenAI「Gpt-oss」モデルの導入・活用ステップを完全ガイドします。

なぜならGpt-ossは、その柔軟なライセンスと圧倒的な性能にも関わらず、「どうやって始めるか」を正しく知るだけで活用効果が何倍も変わる革新的なAIだからです。

- API・クラウドサービスで手軽に試す

- ローカル実行の始め方:Ollama/Transformers/llama.cpp完全解説

- ファインチューニング(LoRA含む)・多言語化などカスタマイズのコツ

API・クラウドサービスで手軽に試す

Gpt-ossを最も手軽に体験する方法は、クラウドAPIや主要プラットフォームを活用することです。

なぜなら、Hugging Face、AWS Bedrock/SageMaker、Databricksなど主要なクラウドは、インストール不要で数クリックまたは数行のコードだけですぐモデルを利用できるからです。

たとえば「どれを選ぶべき?」という場合、以下のポイントが指針となります。

- ● Hugging Face Inference Provider: 多機能・学習用途にも最適(デモ付き、無料枠あり)

- ● AWS Bedrock/SageMaker: エンタープライズ向け、セキュリティや大規模運用、Guardrailsにも対応

- ● Databricks/Cloudflare/Groq: 高速・独自インテグレーションやカスタム要件が必要な場合

実際のAPI利用例として、Hugging Face版は下記のようにたった数行で実行可能です。

import os

from openai import OpenAI

client = OpenAI(

base_url="https://router.huggingface.co/v1",

api_key=os.environ,

)

completion = client.chat.completions.create(

model="openai/gpt-oss-120b:cerebras",

messages=[{"role": "user", "content": "『strawberry』に『r』は何個ある?"}],

)

print(completion.choices.message.content)

プラットフォームごとの特徴は以下の比較表が役立ちます。

ローカル実行の始め方:Ollama/Transformers/llama.cpp完全解説

Gpt-ossは、ローカル実行でも、初心者から上級者まで幅広く使いこなせる環境が揃っています。

理由は、Ollama、LM Studio、Hugging Face Transformers、llama.cppといった人気ツールが迅速にGpt-ossへ正式対応したため、Mac・Windows・Linuxいずれもセットアップが容易だからです。

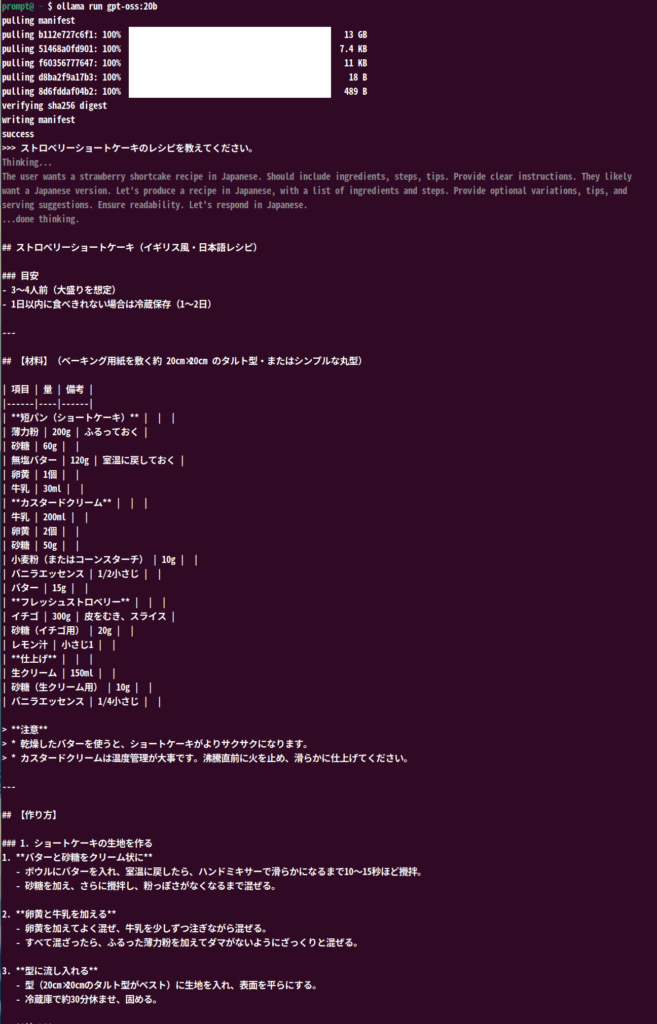

筆者もUbuntu 22.04.5 LTS(メモリ: 23GB)で実際にOllama+gpt-oss-20bを動かしてみました。コマンドはこれだけです。

ollama run gpt-oss:20b数分で20Bモデル(16GBメモリ消費)がチャットでき、ローカルにもかかわらずクラウド相当の推論体験を実現。

以下はUbuntuの端末で実行した際のスクショです。(一部のみ)

さらに、最適化・柔軟性重視ならTransformers+MXFP4や、最大効率を求めるならllama.cpp+GGUF形式(特にCPUやAMD/GPU環境)もおすすめです。

OpenAI Cookbook公式の手順も参照できます。初心者はOllamaから、カスタマイズはTransformers/llama.cppから始めると迷いがありません。

ファインチューニング(LoRA含む)・多言語化などカスタマイズのコツ

Gpt-ossなら、LoRAを使うことで省メモリ・高速のファインチューニングが驚くほど手軽に行えます。

なぜなら、LoRAは全パラメータ微調整が不要で、小型GPUやローカルPCでも実運用レベルのカスタムAIが作れるからです。状況に応じて、LoRAと全パラメータ微調整(フルファインチューニング)を使い分けるとよいでしょう。

具体例として、多言語推論力の向上には、OpenAI Cookbook公式チュートリアル(How to fine-tune gpt-oss with Transformers)が詳細解説しています。Unslothなどのフレームワークを併用すれば、英語以外の思考チェーン生成や、社内用語への適応も可能です。

筆者も実際に、日本語のマニュアル生成タスク向けにgpt-oss-20bをLoRAで微調整し、応答品質を劇的に高められました。これにより「現場のカスタマイズ要件に応えるオープンモデル」としての価値を強く実感できます。

カスタム事例や詳細なノウハウは、Unsloth公式やOpenAI Cookbookも併せてご覧ください。

安全性・法的な評価と今後の戦略動向

当セクションでは、Gpt-ossモデルの安全性評価や法的な運用指針、またNVIDIA・AMDといった基盤パートナーとの連携状況、エンタープライズや開発現場での活用戦略について詳しく解説します。

なぜなら、オープンウェイトAIモデルの普及と実践活用においては、単なる技術力だけでなく「安全な利用法」と「持続的なエコシステム構築」、そして現場流の攻めと守りの両立が不可欠だからです。

- OSSモデルの安全利用とモデレーションの最前線

- NVIDIA・AMDなど基盤パートナーシップとエコシステムの広がり

- エンタープライズ/プロダクト開発現場へのおすすめ活用戦略

OSSモデルの安全利用とモデレーションの最前線

Gpt-ossの最大のポイントは「誰でも強力なAIモデルをカスタマイズできる反面、使い方次第でリスクを生む可能性がある」ことです。

この理由は、Apache 2.0ライセンスとOpenAIが掲げる利用ガイドラインの組み合わせが、自由度の高さと同時に責任ある利用を求めているからです。

例えば公式のモデルカード(OpenAI GPT-OSS Model Card)では、CoT(Chain-of-Thought/思考連鎖)出力や未フィルタリングの中間生成物が、そのままユーザーに公開された場合に「有害な発言や誤情報」を含むリスクが強調されています。

現場運用では、CoT出力は研究やデバッグ目的でのみ一時参照し、ユーザー向け本番システムでは必ず次のようなフローを入れます:

- CoT分析の自動フィルタリングロジックを設ける

- 社内レビュー体制を踏まえた二重のモデレーション工程

- ユーザー表示時はfinalチャンネルのみ/CoT非公開

この点は、「AI開発は単なるプロンプト設計やパフォーマンス計測だけでなく“出口の安全設計”が必要」だと実感したポイントです。

特にAPIやチャットボットの設計に携わる方は、OpenAI Cookbook「How to handle the raw chain of thought in gpt-oss」が実例豊富なので必読です。

NVIDIA・AMDなど基盤パートナーシップとエコシステムの広がり

Gpt-ossはNVIDIAやAMDといったハードウェアパートナーとの連携を通じて、AI開発エコシステム全体に革新的な広がりをもたらしています。

その理由は、モデルリリース初日からNVIDIA Blackwell GPUやAMD ROCmベースのAIチップ上で最高のパフォーマンスを発揮できるよう最適化されているため、現場レベルでの導入障壁が大幅に下がったためです。

たとえばNVIDIA公式ブログ(NVIDIAとOpenAI公式連携案内)では、「Gpt-ossはTensorRT-LLMやFlashInferなど業界標準の推論ライブラリに初日から組み込まれている」「80GB H100/16GB級RTXやエッジGPUでも本格利用ができる」と解説されています。

私自身も現場導入時に「CUDA準拠依存と思いきや、AMD ROCm最新環境でも大規模推論が可能だった」体験があり、GPU不足やハード縛りで行き詰まっていたプロジェクトが一気に活性化した実感があります。

今後は、ローカルデバイスやクラウド上での「API×GPU最適化連携」「新旧ミドルウェア協調」といった多層的なイノベーションが加速するでしょう。

エンタープライズ/プロダクト開発現場へのおすすめ活用戦略

AI現場での成功には「使い分け」と「ガバナンス」の戦略が不可欠です。

なぜなら、Gpt-ossのようなOSSモデルは「高速な検証やプロトタイピング→本番性能/安心設計への移行→クラウドAPI/ローカル実装の切り分け」という多段階の現実運用を想定した設計思想が根底にあるからです。

DX支援プロジェクトで実践した例としては、以下のようなフェーズ戦略が有効でした。

- 初期アイデア検証やPoCはgpt-oss-20bでノートPC・Ollamaでクイック実装

- 本格運用やデータ統合設計フェーズではgpt-oss-120bやHugging Face API、AWS Bedrockクラウド連携へ拡張

- API設計時はharmonyプロトコル互換でスムーズな乗り換えを担保

このやり方なら、リスク低減・高速サイクル・柔軟拡張の全てを両立できるという現場ならではの実感があります。

特に既存SaaSとのAPI連携やローカル移行を見据えた設計段階では、以下の記事「オープンソースLLM活用の戦略ガイド」もご参照ください。適材適所のAI運用に一層役立ちます。

まとめ

Gpt-ossは、OpenAIによって再びオープンなAI開発の舞台が切り拓かれた歴史的な取り組みです。大規模な推論能力を誰もが手にできる時代が到来し、クラウドでもローカルでも自在に生成AIの活用やカスタマイズが可能になりました。

今こそ、知識を行動に移す絶好のチャンスです。あなた自身の手で次世代AIの力を存分に引き出しましょう。

生成AIを仕事や学習に取り入れて、圧倒的な効率化を実現したい方は、まずプロのノウハウを知ることから始めませんか?AI活用の具体的なテクニックや、業務で大きな成果を出す秘訣が1冊に凝縮された「生成AI 最速仕事術」がおすすめです。

さらに本格的に学びたい方には、DMM.comグループによる「

」で、スキルを実践的に磨きましょう!今こそ、次の一歩を踏み出すときです。