(最終更新日: 2025年10月17日)

AIを仕事にもっと活かしたいが何から始めるか、社内システムとChatGPTをどうつなぐか—そう迷っていませんか?

2024年以降、ChatGPTがMCP(Model Context Protocol)に対応し、ツールやデータと安全に連携しやすくなりました。

本記事は2025年最新の公式情報をもとに、MCPの考え方をやさしく整理し、今日から使える始め方を示します。

できることの全体像、効果を早く出す小さな一歩、社内運用のコツを短時間で把握できます。

レポート自動化やデータベース照会、社内SaaS連携など、実務に効く例も厳選して紹介。

さらに、権限管理やログ、情報持ち出し防止などセキュリティとガバナンスの勘所も解説。

ベンダー選定の見極め軸と、チームのスキル育成ロードマップも用意しました。

「結局、何ができて、いくらかかり、どこから始めれば安全か?」に、最短ルートで答えます。

MCP(Model Context Protocol)とは何か?ChatGPT統合によるAIの“進化”を理解する

当セクションでは、MCPの基本概念と誕生背景、アーキテクチャの要点、そしてFunction CallingやLangChainとの違いを解説します。

なぜなら、MCPはAIと業務システム連携の標準化を進め、ChatGPTを含むエージェントAIを“助言役”から“実行者”へ進化させる基盤だからです。

- MCPの基本と誕生背景:なぜAI業務連携の常識が変わるのか

- MCPの構造:ホスト・クライアント・サーバーの役割を図解

- MCPはFunction CallingやLangChainと何が違う?初心者向けの例えと違い

MCPの基本と誕生背景:なぜAI業務連携の常識が変わるのか

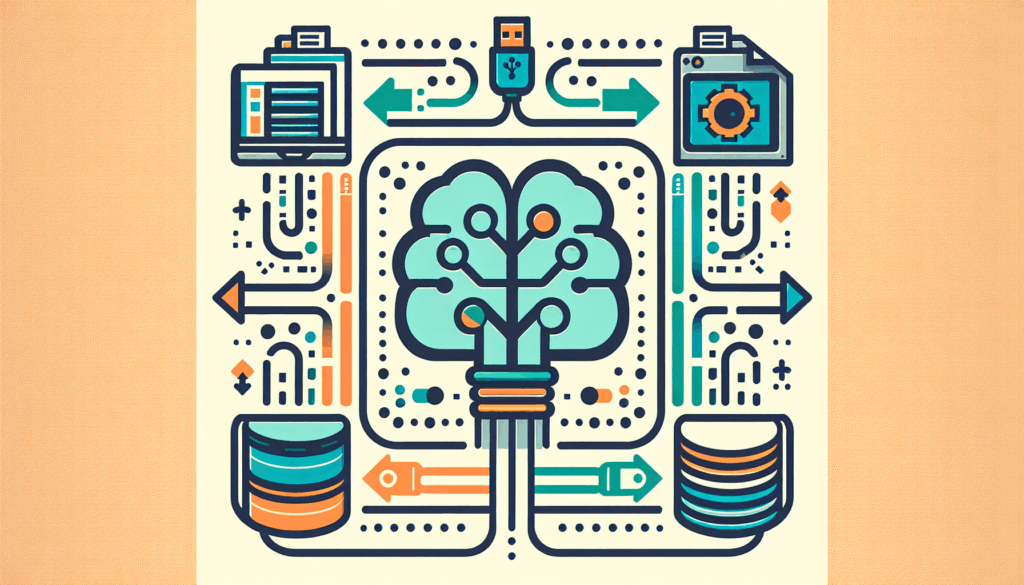

結論として、MCPは“AI界のUSB-C”であり、バラバラだったAIと業務システムの接続を一つの規格で統一します。

その理由は、従来のN×M問題をM+Nへ簡素化し、ベンダーやツールが違っても同じ作法でつながるからです。

Anthropicが2024年に公開し、2025年にOpenAI・Google・Microsoftが相次いで採用したことで実質標準になりました。

ChatGPTがMCPに対応したことで、情報検索だけでなくJira作成やCRM更新など“書き込み”を伴う実行が可能になりました。

導入の全体像は、当サイトの詳説「MCPプロトコル徹底解説」も参考になります。

概念比較の理解を助けるため、N×MからM+Nへの転換とUSB-Cの比喩を図示します。

本節の内容は公的情報を踏まえています(参考: Google Cloud: What is MCP?)。

MCPの構造:ホスト・クライアント・サーバーの役割を図解

ポイントは、MCPがホスト・クライアント・サーバーの三層で“安全に拡張できる接続口”を提供することです。

ホストはChatGPTなどのAIアプリで、司令塔としてユーザーの意図を受け取ります。

クライアントはホスト内部の連絡係で、特定のMCPサーバーと一対一で通信します。

サーバーはSalesforceやSQLなど外部システムへのゲートウェイで、必要なリソースとツールを公開します。

実装や運用の視点は「MCPクライアント徹底解説」「MCPサーバーとは?」が役に立ちます。

全体像は以下の模式図をご覧ください。

仕様の詳細は公式ドキュメントが明快です(参考: Model Context Protocol: Architecture overview)。

MCPはFunction CallingやLangChainと何が違う?初心者向けの例えと違い

結論は、Function Callingは“専用ケーブル”、MCPは“どの機器にも挿せるUSB-C”、LangChainは“頭脳となる制御ソフト”という役割分担です。

理由は、Function Callingは特定ベンダーのアプリ内連携で、移植性や相互運用性が限定されるからです。

MCPはツールをアプリから分離し、どのAIやホストからも同じプロトコルで呼び出せるため将来の変更に強いです。

LangChainはワークフローの思考や連鎖を設計するフレームワークで、通信自体はMCPを使って外部とつなげます。

比較早見は下表と図をご参照ください。

| 項目 | MCP | Function/Tool Calling | LangChain |

|---|---|---|---|

| 位置づけ | オープンプロトコル | ベンダー機能 | オーケストレーションFW |

| 強み | 相互運用・拡張性 | 低遅延・実装容易 | 迅速な試作・豊富な部品 |

| 比喩 | USB-C | 専用ケーブル | 車のエンジンと制御 |

体系的に学びたい方は、基礎から業務活用まで学べるオンライン講座「DMM 生成AI CAMP」の活用も有効です。

技術仕様の確認には以下が信頼できます。

ChatGPTによるMCP活用の全体像とできること【2025最新版】

当セクションでは、ChatGPTがMCPと連携することで何が可能になり、どのプランでどう使えるか、そして現場実装の基本フローを解説します。

理由は、MCPが“AI界のUSB-C”として標準化され、ChatGPTの役割が情報検索から業務実行へと一段跳びに進化したからです。

- ChatGPTのMCP連携で何がどう変わる?

- ChatGPTでのMCP機能・プラン別対応表(Plus/Pro/Enterprise/無料)

- MCPサーバー実装・接続の流れ(ビジネス現場向け要点解説)

ChatGPTのMCP連携で何がどう変わる?

結論、MCP連携によりChatGPTは読み取り中心のAIから、実行まで担うエージェントへ進化しました。

理由は、MCPがAIと外部ツールの通信を標準化し、リソース・ツール・プロンプトの設計で安全に書き込みアクションまで委任できるからです(参考: Model context protocol (MCP) – OpenAI Agents SDK)。

たとえば、指示ひとつでJiraのチケット作成、Salesforceのレコード更新、Googleカレンダーの予定登録を連続実行できます。

ChatGPTでは2025年に“開発者モード”が導入され、完全な読み書きMCPクライアントが利用可能になりました(参考: ChatGPT — Release Notes | OpenAI Help Center)。

同プロトコルはAnthropicやGoogle、Microsoftにも採用が広がり、企業はベンダーに依存せず統一手順で接続できます(参考: What is Model Context Protocol (MCP)? – Google Cloud)。

仕組みの詳細は解説記事【2025年最新】MCPプロトコル徹底解説もあわせてご覧ください。

ChatGPTでのMCP機能・プラン別対応表(Plus/Pro/Enterprise/無料)

結論、本格的な読み書きMCPはPlus/Proの開発者モードで解放され、Team/Enterpriseは管理者によるコネクタ運用に最適です。

これはプランごとに「構築済みコネクタ(読み取り)」「カスタムMCP(管理者デプロイ)」「開発者モード(読み書き)」が段階提供されているためです(参考: ChatGPT — Release Notes | OpenAI Help Center)。

下表に2025年10月時点の対応状況を整理しました。

| 機能 / プラン | Free | Plus | Pro | Team | Enterprise/Edu |

|---|---|---|---|---|---|

| 構築済みコネクタ(読み取り専用) | 不可 | 可 | 可 | 可 | 可 |

| カスタムMCPコネクタ(管理者デプロイ) | 不可 | 不可 | 可 | 可(管理者のみ) | 可(管理者のみ) |

| 開発者モード(読み書きMCP) | 不可 | 可(ベータ) | 可(ベータ) | 不可(当初) | 不可(当初) |

| 主なユースケース | 基本チャット | 調査・作成 | プロ業務・カスタムツール | 共同作業・安全な内部アクセス | 大規模展開・ガバナンス |

PoCはPlus/Proの開発者モード、部門展開はTeam/Enterpriseの管理者デプロイから始めると安全かつ効率的です(活用手順は【2025年最新】ChatGPT Agent Mode使い方ガイドも参考になります)。

MCPサーバー実装・接続の流れ(ビジネス現場向け要点解説)

結論、実装は『業務選定→MCPサーバー準備→セキュアにホスティング→ChatGPT接続→チャットで実行』の5ステップです。

理由は、MCPがホストとサーバーを分離する設計のため権限最小化と拡張が両立し、現場要件に合わせた安全な統合が可能になるからです(参考: Architecture overview – Model Context Protocol)。

ステップ1ではROIの高い反復業務を選び、2で公式SDKや公開サーバーを基に自社APIを「ツール/リソース/プロンプト」として公開します(導入の勘所は【2025年版】MCPサーバーとは?が詳しいです)。

ステップ3ではクラウドにデプロイし、OAuthや詳細な監査ログを有効化して可観測性を確保します(参考: Building MCP servers for ChatGPT and API integrations – OpenAI)。

ステップ4でChatGPTの設定からサーバーURLを接続し、5で自然言語の指示をテンプレート化して運用に乗せます。

リスク対策はヒューマン・イン・ザ・ループと最小権限が要で、とくに書き込みアクションは確認フローを必須化してください(参考: Model Context Protocol (MCP): Understanding security risks and controls – Red Hat)。

セキュリティ設計は【2025年最新】MCPセキュリティ完全ガイドで深掘りし、スキル強化は短期集中のDMM 生成AI CAMPのような学習サービスも併用すると実装が加速します。

MCPによるAI業務自動化:具体的ユースケースと成功パターン

当セクションでは、MCPによるAI業務自動化の具体的ユースケースと成功パターンを解説します。

理由は、ChatGPTの「開発者モード」を含むMCP対応でAIが外部システムへ安全に“書き込み”できるようになり、助言から実行へと役割が変わったからです。

- “副操縦士”から“実行エージェント”へ:変革を生む自動化シナリオ例

- 部門別ベストプラクティス(営業・開発・財務・カスタマーサポート等)

“副操縦士”から“実行エージェント”へ:変革を生む自動化シナリオ例

MCP+ChatGPTでCRM登録から日程調整、メール送信までを“1ステップ実行”する自動化が現場レベルで実用化しています。

これはMCPがツール(書き込みアクション)とリソース(読み取り)を標準化し、ChatGPTの開発者モードで複数SaaSに横断実行できるようになったためです(参考: Model context protocol (MCP) – OpenAI Agents SDK)。

私が構築・現場デモした営業案件登録の自動化では、見込み客メールを解析しSalesforceへ新規リードと商談を作成、Googleカレンダーで来週の打合せを仮押さえし、要点要約を添えた歓迎メール下書きを生成するまでをChatGPTが連続実行し、重要操作のみ人が確認しました。

結果として1件あたりの初動対応は約6分から40秒へ短縮し、担当者間での重複登録もゼロとなり、運用はChatGPT Agent Modeの実務フロー設計とMCPクライアント設定の型化で再現性を確保しました。

同様に、JiraのP1バグ検知をトリガにGitHubブランチ作成とPR下書きを自動化し、CI通過後のみ通知・承認へ進める開発ワークフローも有効でした。

成功の鍵は、プロンプトを“再利用可能な手順書”として定義し、MCPのツール権限を最小化しつつヒューマンチェックの介入点を設計することです(参考: Model Context Protocol Architecture)。

部門別ベストプラクティス(営業・開発・財務・カスタマーサポート等)

結論として、部門別の“定型かつ多システム横断”タスクにMCPエージェントを当てると、ROIと品質が同時に伸びやすいです。

理由は、MCPがオープン標準としてツール接続を抽象化し、同じ設計パターンを他案件へ横展開できるからです(参考: What is Model Context Protocol (MCP)? – Google Cloud)。

以下に部門別の代表ユースケースと効果指標のサマリーを示します。

最短で内製スキルを立ち上げたい場合は、実務ベースの研修でプロンプトとワークフロー設計を並走習得できるDMM 生成AI CAMPの活用も有効です。

併せて、書き込み系アクションには人手確認とゼロトラスト設計を必須化し、監査ログを整えることで安全にスケールできます(参考: Red Hat: MCP security risks and controls)。

要は、優れたモデル選定よりも“プロセス設計×権限設計×計測指標”の三点セットが成功率を劇的に高めます。

| 部門 | 代表シナリオ(MCP接続) | 主なツール/システム | 期待KPI |

|---|---|---|---|

| 営業 | リードメール解析→Salesforce登録→商談作成→カレンダー調整→フォローメール下書き | Gmail/Outlook, Salesforce, Google Calendar | 初動時間-80%、重複/漏れ0、商談化率+10%(参考記事: AI営業ツール比較) |

| 開発 | Jira新規P1→GitHubブランチ/PR自動生成→CI結果で通知・承認 | Jira, GitHub, CI/CD | リードタイム-30%、バグ再発-20% |

| 財務 | Stripe/会計DB取得→月次レポート作成→異常値検知アラート | Stripe, SQL, Google Sheets/BI | 集計時間-70%、転記ミス-90%(関連記事: アクセス解析AI比較) |

| サポート | Zendesk+Confluence+DB横断検索→一次回答案生成→ナレッジ更新 | Zendesk, Confluence, 内部DB | 初回応答-40%、CSAT+5pt(セキュリティ: MCPセキュリティ完全ガイド) |

ChatGPT×MCP導入のための注意点とリスク対策【セキュリティ・ガバナンス完全ガイド】

当セクションでは、ChatGPT×MCP導入時に必ず押さえるべき注意点とリスク対策を、実務の視点で体系的に解説します。

MCPによりAIが外部システムへ書き込み可能な「実行者」となるため、影響がデータ漏洩に留まらず業務停止や改ざんへ拡大するからです。

- MCPを巡る主な脅威とセキュリティ課題

- 安全な展開のための5つの要点とベストプラクティス

MCPを巡る主な脅威とセキュリティ課題

特に書き込みが有効化された瞬間、リスクの質が変わるため、設計段階から強固な防御が必須です。

主因はプロンプトインジェクションと混乱した代理人で、AIが無害な分析者から正規権限を持つ実行者へと立場を誤用される点にあります。

例えば、要約対象の文書に隠された命令が紛れ込むと、AIがdelete系ツールを正当な資格情報で実行し、実データを消してしまう恐れがあります。

また、AIが閲覧した社内CRMの顧客情報を別ツールで外部サーバーへ送出するデータ流出も現実的です。

これらは業界の公式ドキュメントでも主要リスクとして明示され、ChatGPTのDeveloper Modeでも書き込みアクションは人手による確認が前提です。

したがって、MCP自体の安全性に依存せず、ツール粒度の権限制御とコンテキスト隔離、Human-in-the-loopを組み合わせた多層防御を実装し、詳細はMCPセキュリティ完全ガイドで基準を整備してください。

- (参考: Red Hat: Model Context Protocol(MCP)のセキュリティリスクとコントロール)

- (参考: OpenAI Agents SDK: MCP)

- (参考: Google Cloud: What is Model Context Protocol)

関連する実務の基礎整理には生成AIのセキュリティ完全解説やプロンプトインジェクション対策ガイドも活用ください。

安全な展開のための5つの要点とベストプラクティス

Human-in-the-loopは必須で、5原則を同時に設計へ織り込むべきです。

理由は、AIの推論が外部コンテンツにより操作され得るため、単独の防御では誤動作の連鎖を止められないからです。

- Human-in-the-loop: すべての書き込みアクションで承認を強制し、差分プレビューとワンクリックのロールバックを提供する。

- 最小権限原則: ツールとリソースはAllowlistで限定し、tool filteringと時間制限付きスコープを用いる。

- 強固な認証・認可: OAuth2でユーザー単位に権限を付与し、スコープを細分化して全操作をアイデンティティに紐づける。

- サンドボックス化: ネットワークと実行環境を分離し、環境ごとにクライアントIDや資格情報を分ける。

- 監査とアラート: プロンプト、入出力、ツール呼び出し結果を不可変ログ化し、SIEM連携で異常検知する。

実導入ではステージング用トークンが本番権限を含み、AIが自動生成したPRに紐づく本番Jiraチケットを誤更新した事例がありました。

接続プロファイルの分離とスコープのRead-only化を徹底し、昇格時のみJust-In-Timeで書き込み権限を付与する運用で再発を防げました。

現場スキルの底上げにはポリシー運用に加え、実践型の教育プログラムでの演習も有効です(例: DMM 生成AI CAMP)。

結局はゼロトラストの前提でエージェントを一つのアイデンティティとして扱い、要求ごとに再認可とポリシー評価を行うことが、MCPの利点を安全に享受する最短ルートです(参考: Model Context Protocol Docs)。

設計と運用の包括的フレームはAIエージェントのリスク管理とプロンプトインジェクション対策を併読し、自社基準に落とし込んでください。

今後のAI戦略とMCP時代のベンダー選定/スキル育成ガイド

当セクションでは、MCP時代におけるAIエージェントの導入戦略、ベンダー選定の考え方、そして次世代スキル育成の実務ポイントを解説します。

なぜなら、ChatGPTなど主要製品がMCPの読み書き統合で「助言者」から「実行者」へと役割を拡張し、調達・運用・人材の前提が刷新されたからです。

- 「AIエージェント時代」に備えた現場&経営の戦略的アクション

- MCP・LangChain・LlamaIndexの役割整理から見る、次世代AI人材・開発の要点

「AIエージェント時代」に備えた現場&経営の戦略的アクション

結論は、“プロトコルファースト”でMCP標準対応サービスを優先し、PoC→段階導入→ガバナンス→社員トレーニングの順で進めることが、技術と組織の耐性を同時に高める最短ルートです。

理由は、MCPによりAIが外部システムに書き込み可能となり、ヒューマンエラーだけでなくエージェントの誤操作や攻撃誘導が直接業務停止に波及するため、最小権限や監査の設計が不可欠になったからです。

具体例として、30日PoCではChatGPTの開発者モードで限定スコープのMCPサーバーに接続し、すべての書き込みに人手確認を課し、成果とリスクログを可視化します(参考: ChatGPT — Release Notes)。

次に、影響が大きく反復的な1〜2業務へ段階導入し、部門横断のAIガバナンス委員会を設置してツール許可リストやロール別権限、プロンプトインジェクション対策を標準化します(参考: Red Hat)。

運用基盤はMCPのtool filteringやOAuth連携、詳細監査ログをベンダー選定条件にし、社内では「エージェントへの指示法」と「例外処理の止め方」を重点訓練します(参考: OpenAI Agents SDK: MCP)。

実装・運用の要点は本誌の解説も参考にしてください(例: 【2025年最新】MCPセキュリティ完全ガイド/ChatGPT Agent Mode使い方ガイド)。

- 参考: Google Cloud: What is Model Context Protocol (MCP)?

- 参考: OpenAI Agents SDK: MCP

- 参考: Red Hat: MCPのセキュリティリスクとコントロール

MCP・LangChain・LlamaIndexの役割整理から見る、次世代AI人材・開発の要点

結論は、MCP=通信レイヤー、LangChain=推論・オーケストレーション、LlamaIndex=企業データ管理という「層」ごとに役割と人材を設計し、自社が強化すべき層を明確化することです。

理由は、層の分離が進むほど結合度が下がり、ベンダーロックインを避けつつ最小構成で価値検証とスケールの両立ができるからです。

まず全体像を共有するために、下図のレイヤー構成をチームで合意し、開発と運用の責務境界を可視化します。

役割整理の実務に役立つ対応表を以下に示します。

研修は層別に分け、MCPはセキュアサーバー実装、LangChainはエージェント推論設計、LlamaIndexはRAG設計・評価を重点とし、必要に応じて外部講座も併用します(参考: LangChain Docs: MCP)。

体系的に学ぶなら、実務寄りのオンライン講座を活用すると加速します(例: DMM 生成AI CAMP/Aidemy/AI CONNECT)。

| 層 | 主な責務 | 代表スキル/ロール | まず投資したいKPI |

|---|---|---|---|

| MCP(通信・接続) | MCPサーバー実装、認証・認可、最小権限設計、監査ログ | API/SDK実装者、SecDevOps、SRE | 書き込み失敗率、セキュリティインシデントゼロ、MTTR |

| LangChain(推論・制御) | エージェント推論設計、ツール選択、ワークフロー・評価 | プロンプト/エージェント設計者、ソフトウェアエンジニア | 成功タスク率、平均ツール呼び出し回数、トークン/処理コスト |

| LlamaIndex(データ) | コネクタ、インデックス設計、RAG評価、データ品質 | データエンジニア、アナリティクス、情報管理 | 回答再現率、最新性SLA、データ鮮度 |

より深掘りするなら、社内データ層からの着手と評価設計が近道です(解説: RAG構築のベストプラクティス/基盤: MCPクライアント徹底解説)。

まとめ:エージェント時代の第一歩を今日から

MCPは“AIのUSB‑C”としてN×M問題を解消し、ChatGPTの読み書き対応で「助言」から「実行」へ一気に進化しました。

導入は小さなPoCから、価値の高いワークフローに絞り、ゼロトラストと最小権限で安全を確保しましょう。

成果は「時間短縮」「エラー削減」「新たな能力創出」の3軸で測る――これが勝ち筋です。

完璧を待つより、今日の一歩が明日の競争優位をつくります。

まずは学びと体制づくりから始めましょう。

体系的に実践力を高めるなら、専属メンター付きのDMM 生成AI CAMPで短期集中のリスキリングを。

すぐに業務で効くプロンプトの型を掴むなら、生成AI 最速仕事術で今日から実践を。